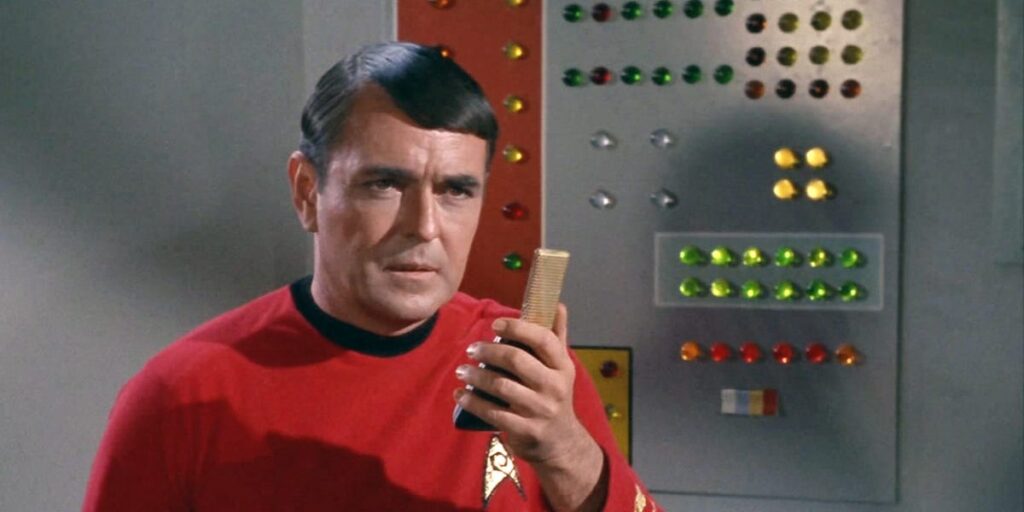

Dans Star Trek, Starship Enterprise avait l’ingénieur en chef Montgomery « Scotty » Scott. Il devait régulièrement expliquer au capitaine Kirk qu’il était impossible d’arrêter de faire certaines choses en raison de la pratique des lois de la physique et autres.

« Le moteur le prend, capitaine! » est une citation célèbre que l’acteur n’a peut-être pas réellement dit dans une émission de télévision. Mais vous avez une idée.

Avec les tendances des agents de l’IA qui prennent de l’ampleur, nous pouvons maintenant approcher un tel moment de l’industrie technologique.

Ce champ commence à passer d’un chatbot relativement simple à un agent d’IA plus capable qui peut effectuer de manière autonome des tâches complexes. Y a-t-il suffisamment de puissance de calcul pour maintenir cette transformation?

Un récent rapport de Barclays montre que l’industrie de l’IA est capable de soutenir 1,5 à 22 milliards d’agents d’IA.

Bien que cela puisse être suffisant pour révolutionner le travail des cols blancs, l’exécution de ces agents peut nécessiter une puissance de calcul supplémentaire tout en répondant à la demande des consommateurs de chatbots.

Tout est sur les jetons

Les agents de l’IA génèrent beaucoup plus de jetons par requête utilisateur que les chatbots traditionnels, ce qui les rend coûteux en calcul.

Les jetons sont le langage de l’IA générateur et sont au cœur du modèle de tarification émergent de l’industrie. Le modèle AI décompose les mots et autres entrées dans les jetons numériques, ce qui les rend plus faciles à traiter et à comprendre. Un jeton est d’environ 3/3 du mot.

Les agents d’IA plus puissants peuvent s’appuyer sur des modèles « inférence » tels que O1 et O3 d’Openai ou R1 de Deepseek. Chaque étape de ces chaînes de pensée doit créer plus de jetons et être traitée par des serveurs et des puces AI.

« Les produits d’agent sont principalement exécutés sur des modèles d’inférence et génèrent environ 25 fois plus de jetons par requête par rapport aux produits Chatbot », écrit un analyste de Barclays.

« Super agent »

OpenAI propose un service Chatgpt Pro qui utilise les derniers modèles d’inférence pour 200 $ par mois. Les analystes de Barclays ont estimé que le service générerait environ 9,4 millions de jetons par abonné par an s’il utilisait le modèle O1 de la startup.

Récemment, il y a eu des rapports de médias selon lesquels OpenAI peut offrir un service d’agent d’IA encore plus fort, qui coûte 2 000 $ par mois ou 20 000 $ par mois.

Les analystes de Barclays ont appelé ces «super agents» et ont estimé que pour chaque utilisateur, ces services pourraient générer entre 36 millions et 356 millions de jetons par an.

Autres puces, capitaine!

C’est une quantité incroyable de jetons qui consomment des montagnes de puissance de calcul.

L’industrie de l’IA compte 16 millions d’accélérateurs en ligne cette année. Ceci est un type de puce AI. Environ 20% de cette infrastructure pourrait être dédiée à l’inférence de l’IA. Il s’agit essentiellement de la puissance de calcul nécessaire pour exécuter les applications AI en temps réel.

Les analystes de Barclays ont averti que si les produits d’agent décollent et sont extrêmement utiles pour les consommateurs et les utilisateurs d’entreprise, ils auront probablement besoin de « plus de puces d’inférence ».

L’industrie de la technologie peut avoir besoin de réutiliser des puces qui étaient auparavant utilisées pour former des modèles d’IA et les utiliser pour l’inférence, ont ajouté les analystes.

Ils ont également prédit que, similaires à ceux développés par Deepseek, ils devraient utiliser des modèles moins chers, plus petits et plus efficaces pour les agents d’IA plutôt que des modèles propriétaires plus chers.