Pruna AI, une startup européenne qui a travaillé sur des algorithmes de compression pour les modèles d’IA, fait jeudi son framework d’optimisation.

Pruna AI a créé un cadre qui applique plusieurs méthodes efficaces, telles que le chaching, l’élagage, la quantification et la distillation, à un modèle d’IA donné.

« Nous normalisons également la sauvegarde et le chargement des modèles compressés, l’application de combinaisons de ces méthodes de compression, et évaluons également votre modèle compressé après l’avoir compressé », a déclaré à TechCranch, co-améliorant Pruna AI et CTO Rach Rachwan.

En particulier, le cadre de Pruna AI peut évaluer s’il y a une perte de qualité significative après avoir compressé un modèle et les gains de performances que vous obtenez.

« Si je devais utiliser une métaphore, nous sommes similaires à la façon dont les étreintes font face aux transformateurs et diffuseurs standardisés – comment les appeler, comment les sauver, les charger, etc. Nous faisons de même, mais pour des méthodes d’efficacité », a-t-il ajouté.

Les grands laboratoires AI ont déjà utilisé diverses méthodes de compression. Par exemple, OpenAI a compté sur la distillation pour créer des versions plus rapides de ses modèles phares.

C’est probablement comment OpenAI a développé GPT-4 Turbo, une version rapide de GPT-4. De même, le modèle de génération d’images Flux.1-Schell est une version distillée du modèle Flow.1 de Black Forest Labs.

La distillation est une technique utilisée pour extraire les connaissances d’un grand modèle d’IA avec un modèle «enseignant-élève». Les développeurs envoient des demandes à un modèle d’enseignant et enregistrent les sorties. Les réponses sont parfois comparées à un ensemble de données pour voir à quel point ils sont accordés. Ces sorties sont ensuite utilisées pour former le modèle étudiant, qui est formé pour approximer le comportement de l’enseignant.

«Pour les grandes entreprises, ce qu’elles font habituellement, c’est qu’elles construisent ces éléments en interne. Et ce que vous pouvez trouver dans le monde open source est généralement basé sur des méthodes uniques. Par exemple, disons une méthode de quantification pour les LLM, ou une méthode de coaching pour les modèles de diffusion.» Mais vous ne pouvez pas trouver un outil qui les agrége tous, ce qui les rend faciles à utiliser et à combiner ensemble. Et c’est la grande valeur que Pruna apporte actuellement. »

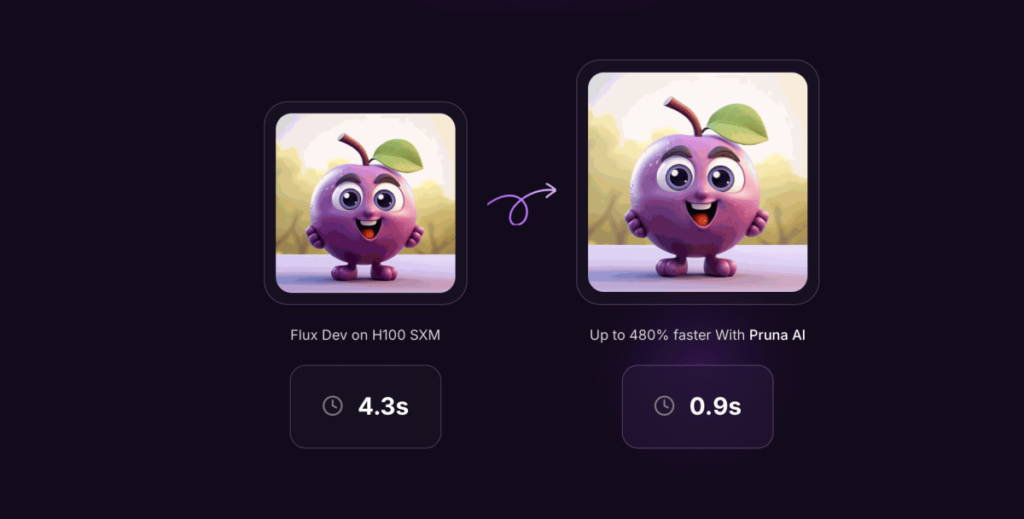

Alors que Pruna AI prend en charge tout type de modèles, des modèles de grande langue aux modèles de diffusion, aux modèles de parole et au texte et aux modèles de vision par ordinateur, la société se concentre davantage sur les modèles d’image et de génération de vidéos en ce moment.

Certains des utilisateurs existants de Pruna AI incluent le scénario et le photoroom. En plus de l’édition open source, Pruna AI propose une offre d’entreprise avec des fonctionnalités d’optimisation avancées incluent un agent d’optimisation.

« La fonctionnalité la plus excitante que nous sortons bientôt sera un agent de compression », a déclaré Rachwan. «Basalement, vous lui donnez votre modèle, vous dites:« Je veux plus de vitesse mais ne dépose pas ma précision de plus de 2%. Et puis, l’agent fera juste sa magie.

Pruna AI facture à l’heure de sa version pro. « C’est similaire à la façon dont vous pensez à un GPU lorsque vous revenez au GPU sur AWS ou tout service cloud », a déclaré Rachwan.

Et si votre modèle est un élément essentiel de votre infrastructure, vous finirez par économiser beaucoup d’argent sur l’inférence avec le modèle optimisé. Par exemple, Pruna AI a réalisé un modèle de lama huit fois plus petit sans trop de perte de son cadre de compression. Pruna AI espère que ses clients penseront à son cadre de compression comme un investissement pour lui-même.

Pruna AI a levé un tour de financement de semences de 6,5 millions de dollars il y a quelques mois. Les investisseurs de la startup comprennent EQT Ventures, Daphni, Motier Ventures et Kima Ventures.