Faites-nous part des mises à jour gratuites

Inscrivez-vous simplement à Myft AI Digest et il sera livré directement à votre boîte de réception.

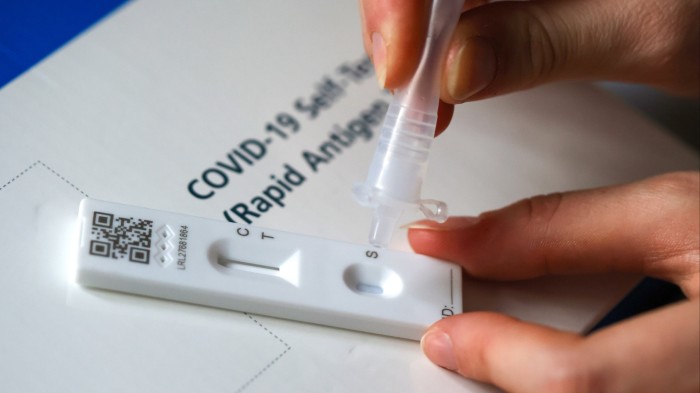

Un de mes proches a entendu quelque chose d’étrange tout en travaillant sur une ligne d’assistance téléphonique pendant la pandémie communautaire. Son travail consistait à aider les appelants à effectuer un test de flux latéral rapide qui a été utilisé des millions de fois pendant le verrouillage. Cependant, certains appelants étaient clairement confus par cette procédure. « Alors je suis ivre de liquide dans le tube. Que dois-je faire maintenant? » J’ai demandé.

Cette confusion de l’utilisateur peut être un exemple extrême d’un problème technique commun. La façon dont les gens ordinaires utilisent des produits et services dans le monde réel peuvent diverger considérablement les intentions des concepteurs du laboratoire.

Parfois, une mauvaise utilisation peut être prudente, pour le meilleur ou pour le pire. Par exemple, les journalistes d’organisations de campagne sans frontières ont cherché à protéger la liberté d’expression dans certains pays autoritaires en cachant du contenu interdit sur les serveurs de jeux vidéo Minecraft. Pendant ce temps, les criminels utilisent des imprimantes 3D ménagers pour fabriquer des armes à feu incontrôlables. Mais le plus souvent, comme les tests covidés, une mauvaise utilisation n’est pas intentionnelle. Il est appelé un problème d’usage inadvert, ou « imp » pour faire court. Le nouveau Gremlins sur la machine pourrait être un chatbot Imp.

En utilisant des chatbots génériques tels que Chatgpt, 17% des Américains l’utilisent pour auto-diagnostiquer leurs problèmes de santé au moins une fois par mois. Ces chatbots ont des capacités techniques incroyables qui semblaient magiques il y a quelques années. Divers tests ont montré que les meilleurs modèles sont désormais cohérents avec les médecins humains en termes de connaissances cliniques, de triage, de résumé de texte et de réponses aux questions des patients. Par exemple, il y a deux ans, une mère britannique a utilisé Chatgpt pour identifier le syndrome du cordon d’attache de son fils (lié à Spina Bifida) qui avait été négligé par 17 médecins.

Cela augmentera la perspective que ces chatbots pourraient un jour devenir une nouvelle «porte d’entrée» pour la prestation des soins de santé et amélioreront l’accès à faible coût. Cette semaine, le ministre britannique de la Santé, Wes Street, s’est engagé à mettre à niveau l’application NHS en utilisant l’intelligence artificielle pour fournir « un médecin dans votre poche pour vous guider à travers vos soins ». Cependant, les méthodes que vous pouvez les utiliser le plus ne sont pas les mêmes que les méthodes qu’elles sont le plus couramment utilisées. Une étude récente dirigée par l’Oxford Internet Institute met en évidence certains défauts désagréables alors que les utilisateurs ont du mal à l’utiliser efficacement.

Les chercheurs ont inscrit 1 298 participants à un essai contrôlé randomisé et ont testé dans quelle mesure ils pouvaient répondre à 10 scénarios médicaux, y compris des maux de tête aigus, des fractures et une pneumonie à l’aide de chatbots. Les participants ont été invités à identifier leur état de santé et à trouver des cours de conduite recommandés. Trois chatbots ont été utilisés: GPT-4O d’Openai, Llama 3 de Meta et Command R + de Cohere. Toutes ces propriétés ont des propriétés légèrement différentes.

Lorsque le scénario de test a été entré directement dans le modèle AI, le chatbot identifie correctement la condition dans 94,9% des cas. Cependant, les participants ont fait bien pire. Ils ont fourni des informations incomplètes, les chatbots ont souvent mal interprété les invites et leur taux de réussite est tombé à seulement 34,5%. Les capacités techniques de ces modèles sont restées inchangées, mais les entrées humaines ont changé, conduisant à des sorties très différentes. Pire encore, les participants aux tests étaient également supérieurs par le groupe témoin, qui n’avait pas accès au chatbot, mais a plutôt consulté le moteur de recherche régulier.

Les résultats de ces études ne devraient pas cesser d’utiliser des chatbots pour des conseils de santé. Cependant, cela suggère que les concepteurs devraient accorder beaucoup plus d’attention à la façon dont les gens ordinaires utilisent leurs services. « Les ingénieurs ont tendance à penser que les gens utilisent de manière incorrecte la technologie. Par conséquent, les dysfonctionnements des utilisateurs sont la faute de l’utilisateur. Mais réfléchir à leurs compétences techniques est fondamental pour la conception », me dit le fondateur de la société d’IA. Cela est particulièrement vrai pour les utilisateurs à la recherche de conseils médicaux. Beaucoup d’entre eux pourraient être des personnes désespérées, malades ou âgées montrant des signes de détérioration mentale.

Des chatbots de soins de santé plus spécialisés peuvent être utiles. Cependant, une récente étude de l’Université de Stanford a révélé que les chatbots de traitement largement utilisés qui aident à relever les défis de la santé mentale pouvaient également « introduire des biais et des obstacles qui pourraient avoir des conséquences dangereuses ». Les chercheurs suggèrent que davantage de garde-corps devraient être inclus afin d’améliorer les invites des utilisateurs, de demander activement des informations pour guider les interactions et communiquer plus clairement.

Les entreprises de haute technologie et les prestataires de soins de santé doivent effectuer beaucoup plus de tests d’utilisateurs en termes réels pour s’assurer que le modèle est utilisé correctement. Le développement d’une technologie puissante est une chose. Apprendre à les déployer efficacement est une autre chose. Faites attention à l’imp.