OpenAI est en train de publier plus régulièrement les résultats de ses évaluations internes de la sécurité des modèles d’IA dans ce que la tenue dit est un effort pour accroître la transparence.

Mercredi, OpenAI a lancé le Hub des évaluations de la sécurité, une page Web montrant comment les modèles de l’entreprise scorent sur divers tests pour la génération de contenu nuisible, le jailbreaks et les hallucinations. Openai dit qu’il utilisera le hub pour partager des mesures sur «Nagoing Base» et qu’il a l’intention de mettre à jour le hub avec des «mises à jour du modèle majeures» à l’avenir.

«Alors que la science de l’évaluation de l’IA évolue, nous aimons partager nos progrès dans le développement de façons plus évolutives de mesurer la capacité et la sécurité des modèles», a écrit Openai dans un article de blog. «En partageant un sous-ensemble de nos résultats d’évaluation de la sécurité ici, nous saurons que cela facilitera non seulement la compréhension des performances de sécurité du système OpenAI au fil du temps, mais soutenons également les efforts de la communauté pour augmenter la transparence sur le terrain.»

OpenAI dit qu’il peut ajouter des évaluations supplémentaires au centre au fil du temps.

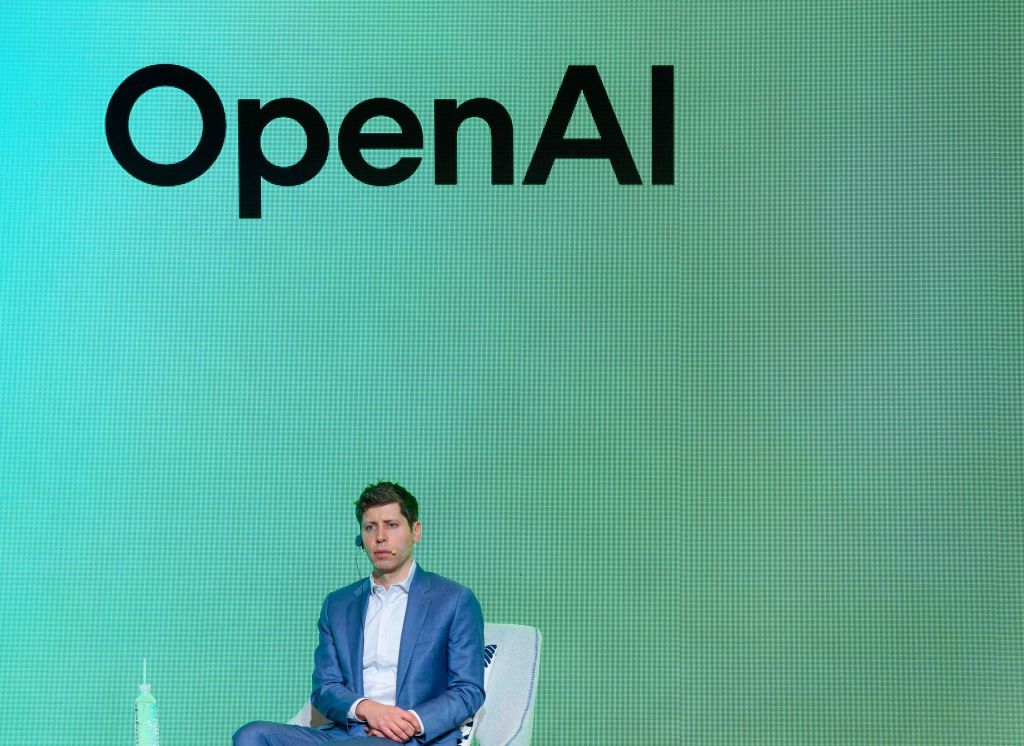

Au cours des derniers mois, Openai a soulevé la colère de certains eshistes pour avoir précipité les tests de sécurité de certains modèles phares et n’ayant pas enregistré de rapports techniques pour les Oters. Le PDG de la société, Sam Altman, a également accusé d’avoir trompé les dirigeants d’OpenAI sur les revues de sécurité des modèles avant sa brève éternité en novembre 2023.

À la fin du mois dernier, Openai a été obligé de faire reculer une mise à jour du modèle par défaut alimentant ChatGPT, GPT-4O, après que les utilisateurs ont commencé à signaler qu’il a respiré une manière trop valide et agréable. X est devenu inondé de captures d’écran de Chatgpt applaudissant toutes les périodes de problèmes, de décisions et d’idées dangereuses.

OpenAI a déclaré qu’il mettrait en œuvre Seveal Seveal et les modifications pour empêcher le fonctionnement de ces incidents, y compris l’introduction d’une «phase alpha» opt-in pour certains modèles qui permettent à certains utilisateurs de Chatgpt de tester les modèles et de donner des commentaires avant le lancement.